Read Paper 《Neural Syntactic Preordering for Controlled Paraphrase Generation》

URL: https://www.aclweb.org/anthology/2020.acl-main.22 https://github.com/tagoyal/sow-reap-paraphrasing

简介

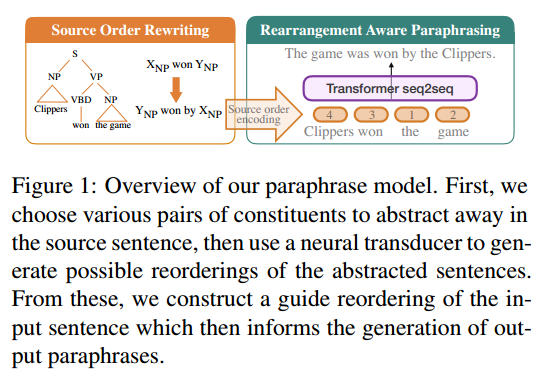

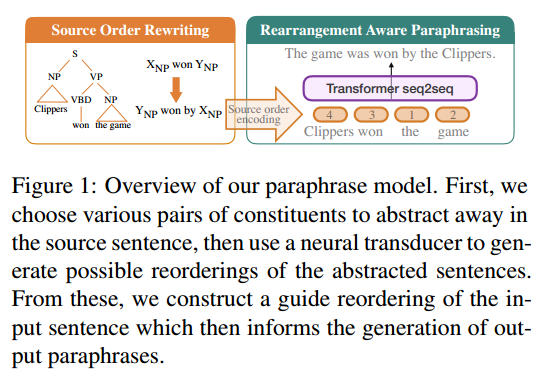

ACL2020 引入输入重排序的方法,通过排序多样性生成多样化复述,并且提升生成质量。

URL: https://www.aclweb.org/anthology/2020.acl-main.22 https://github.com/tagoyal/sow-reap-paraphrasing

ACL2020 引入输入重排序的方法,通过排序多样性生成多样化复述,并且提升生成质量。

本文中,我们纵览Transformer和胶囊网络的主要模块并尝试画出两个模型不同部分的联系。这里的目标是理解两者是否本质上不同,亦或他们有什么关联。 译自Samira Abnar's Post

URL: https://www.ijcai.org/proceedings/2019/760

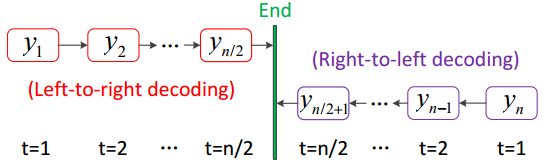

IJCAI2019 一种从两边到中间的序列生成方法,并证明对机器翻译和文本摘要能有速度和精度的同时提升。

URL: https://www.aclweb.org/anthology/D19-1309

EMNLP2019 一种端到端的复述模型,将使用LSTM的条件变分自编码器作为生成对抗网络的生成器,达到了SOTA。

URL: https://aaai.org/ojs/index.php/AAAI/article/view/4665

AAAI2019 通过随机初始化和导向生成与之前不同的复述实现多样化,其中拼凑了多种复述相关数据集。