Read Paper 《Is Word Segmentation Necessary for Deep Learning of Chinese Representations?》

URL: https://www.aclweb.org/anthology/P19-1314

简介

ACL2019 探索神经网络大行其道的时代中文研究中分词的必要性,发现不分词只分字效果近似甚至更好。同时本文列举了大量中文任务数据集。

URL: https://www.aclweb.org/anthology/P19-1314

ACL2019 探索神经网络大行其道的时代中文研究中分词的必要性,发现不分词只分字效果近似甚至更好。同时本文列举了大量中文任务数据集。

URL: https://www.aclweb.org/anthology/C18-1230

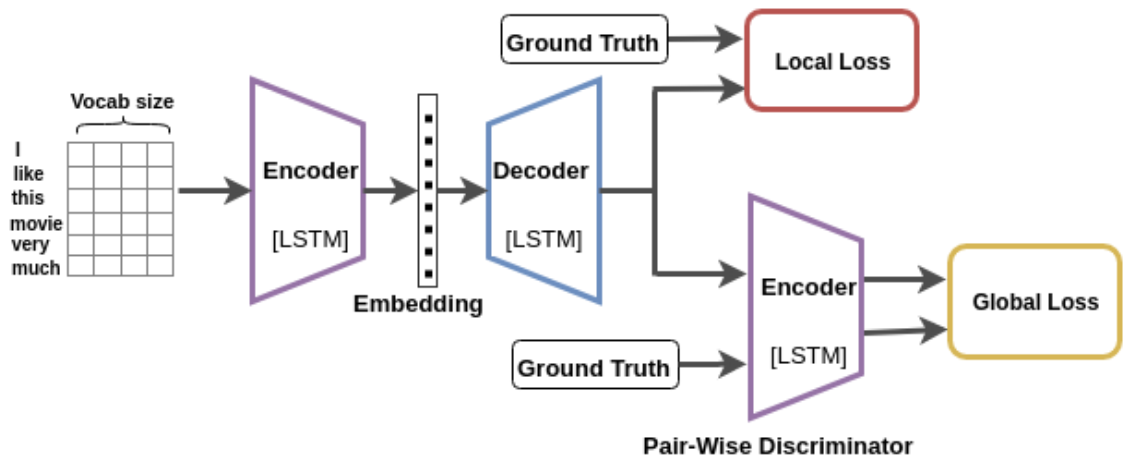

COLING2018 通过复述任务学习句子编码,网络单元使用的LSTM,其复述生成实验到2019年底仍然是SOTA。

| Abbr | Name | Link | Scale | Desc |

|---|---|---|---|---|

| WMT | Workshop on Statistical Machine Translation | https://www.statmt.org | GB | 统计机器翻译研讨会,每年举行机器翻译评测,数据集规模大、多样且开放 |

| IWSLT | International Workshop on Spoken Language Translation | http://iwslt.org | MB | 口语翻译国际研讨会,在TED演讲数据集上评测,每年递增数据且开放 |

| MT | Open Machine Translation Evaluation | https://www.nist.gov/itl/iad/mig/open-machine-translation-evaluation | KB | 美国标准技术研究所的机器翻译评测,数据需要通过语言数据联盟注册获取,小规模新闻翻译 |

URL: https://www.aclweb.org/anthology/D19-1139

EMNLP-IJCNLP2019 用单独的RNN为Transformer学习位置编码,取得更好的效果。

URL: http://papers.nips.cc/paper/9516-paraphrase-generation-with-latent-bag-of-words.pdf https://github.com/FranxYao/dgm_latent_bow

NIPS2019 唯一一篇复述生成论文,扩展序列到序列模型在不牺牲端到端优势的情况下实现良好的解释性。