Read Paper 《Hybrid-Attention based Decoupled Metric Learning for Zero-Shot Image Retrieval》

Contents

URL: http://openaccess.thecvf.com/content_CVPR_2019/papers/Chen_Hybrid-Attention_Based_Decoupled_Metric_Learning_for_Zero-Shot_Image_Retrieval_CVPR_2019_paper https://github.com/chenbinghui1/Hybrid-Attention-based-Decoupled-Metric-Learning

TL;DR

CVPR 2019 提出解耦指标使得零样本学习可以得到更关键更有效的信息。

Dataset

- CUB-200: 加州理工200种鸟类的图片数据集。http://www.vision.caltech.edu/visipedia/CUB-200-2011.html

- CARS-196: 斯坦福包含196种汽车的图片的数据集。http://ai.stanford.edu/~jkrause/cars/car_dataset.html

- Stanford Online Products: 斯坦福在线商品的图片数据集。ftp://cs.stanford.edu/cs/cvgl/Stanford_Online_Products.zip

- InShop: 香港中文大学服饰检索数据集。http://mmlab.ie.cuhk.edu.hk/projects/DeepFashion/InShopRetrieval.html

Algorithm/Model

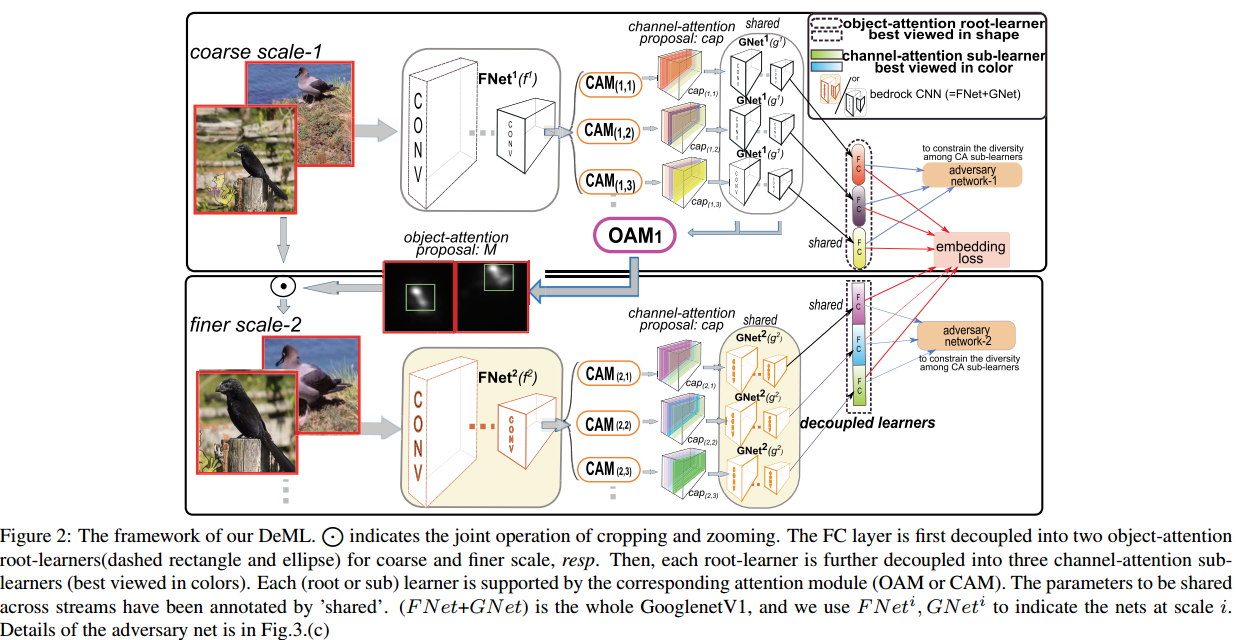

为了让模型不陷入部分细节,根据分治的直觉,作者尽可能的使得原始特征被不同的学习器学习。

基于注意力机制,分为不同的目标注意力模型(OAM),对于每个目标注意力模型,再用多个通道注意力模型来分别学习每个通道的特征。组成分层注意力机制。

其中目标注意力由随机游走方法学习得到,通道注意力模型采用对抗方式谋求其学得的参数尽可能不同。

损失函数由二项偏差损失和二次正则组成,并有避免全零解的项。

为了让模型不陷入部分细节,根据分治的直觉,作者尽可能的使得原始特征被不同的学习器学习。

基于注意力机制,分为不同的目标注意力模型(OAM),对于每个目标注意力模型,再用多个通道注意力模型来分别学习每个通道的特征。组成分层注意力机制。

其中目标注意力由随机游走方法学习得到,通道注意力模型采用对抗方式谋求其学得的参数尽可能不同。

损失函数由二项偏差损失和二次正则组成,并有避免全零解的项。

Experiment Detail

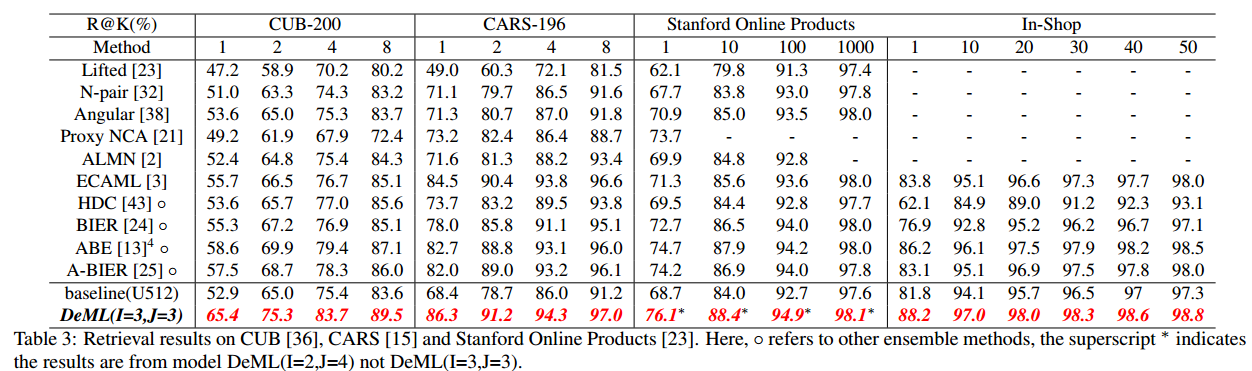

作者对比了零样本学习的以往研究取得了最优的结果。

进行了消融实验,证明了解耦和对抗损失的作用。

进行了消融实验,证明了解耦和对抗损失的作用。

Thoughts

代码竟然用的caffe和matlab。

Author lvcudar

LastMod 2019-08-03